はじめに

この記事は BBSakura Networks Advent Calendar 2023 の 1 日目の記事です。

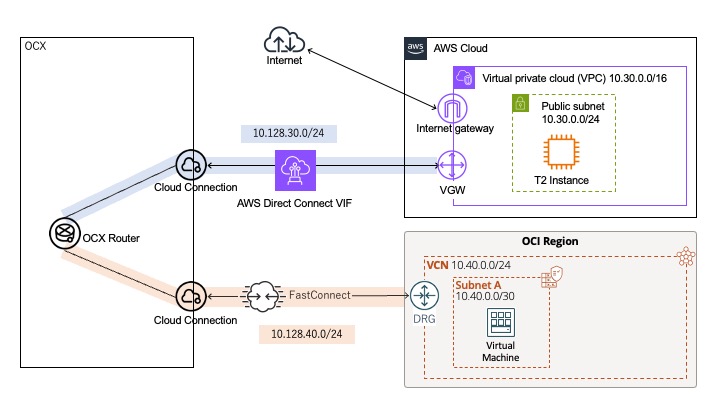

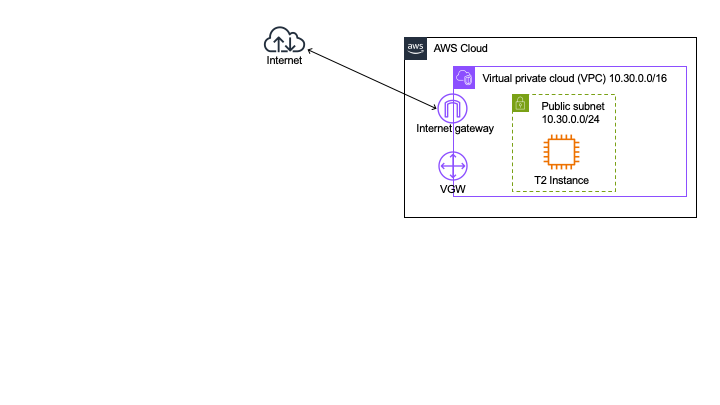

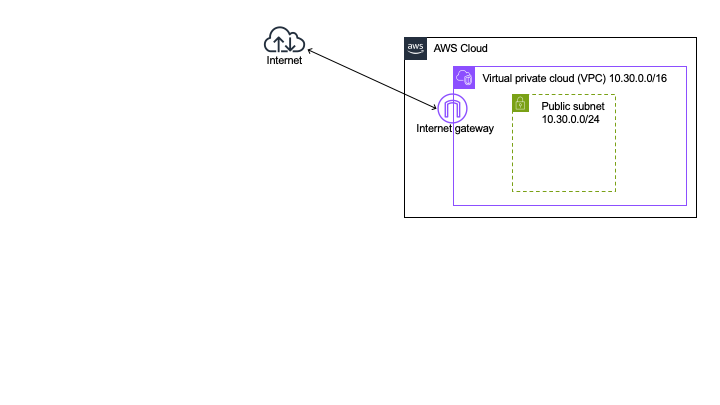

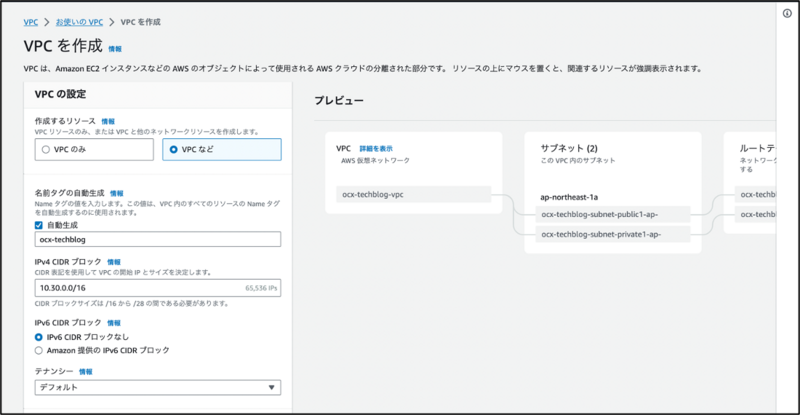

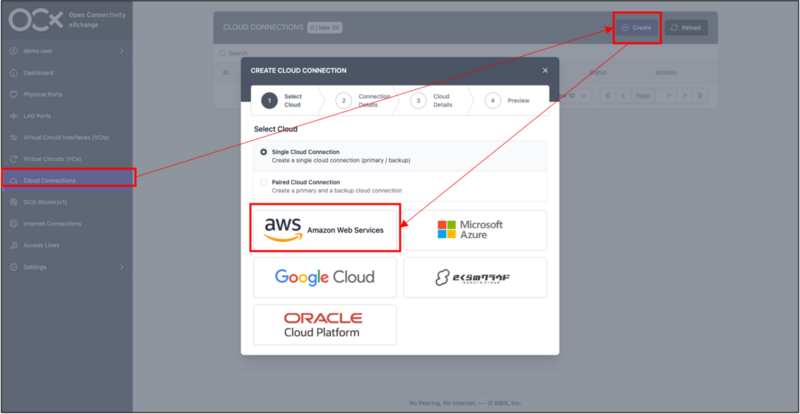

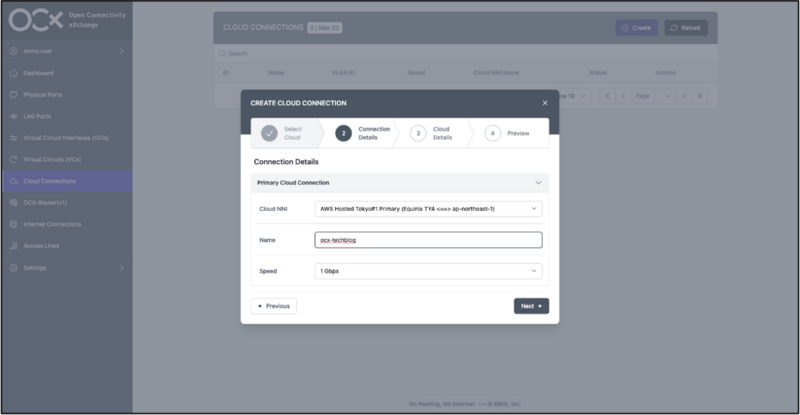

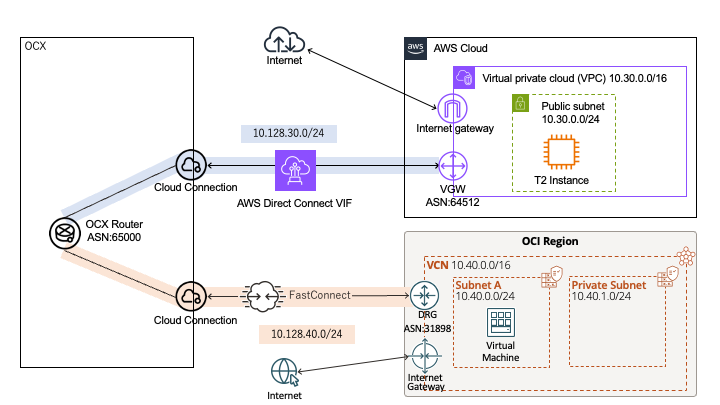

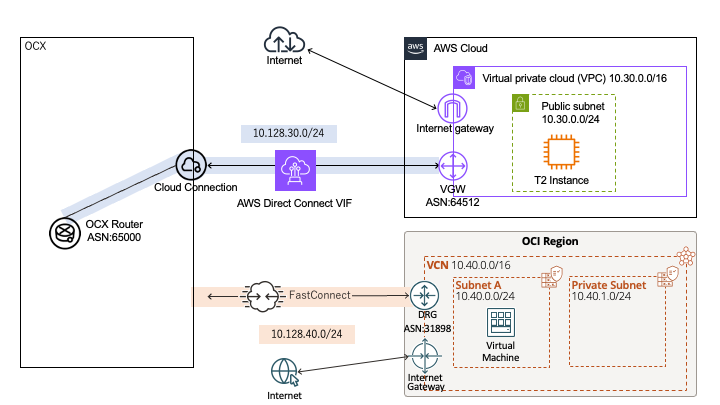

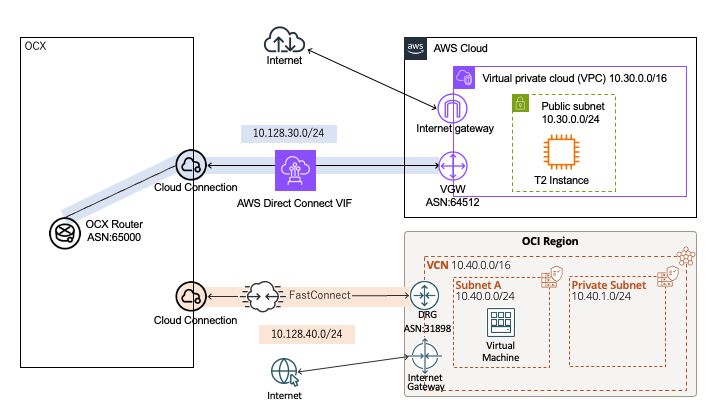

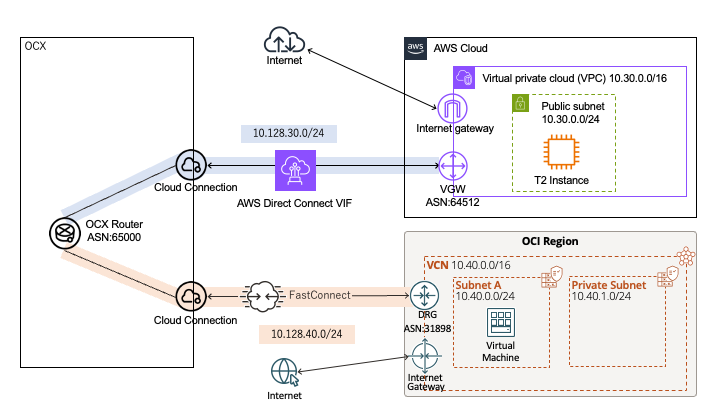

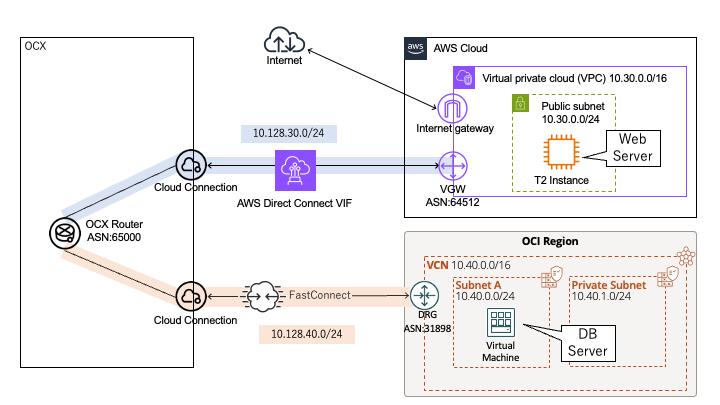

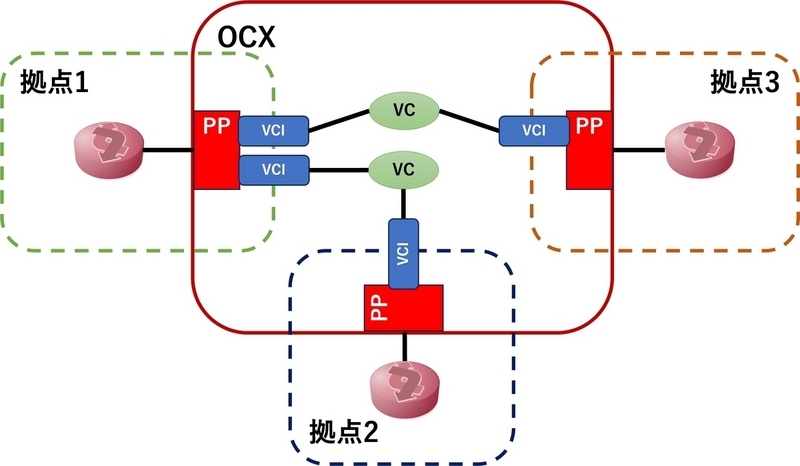

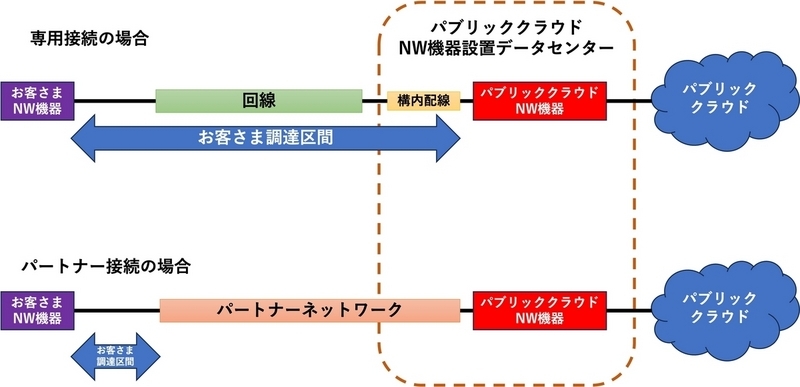

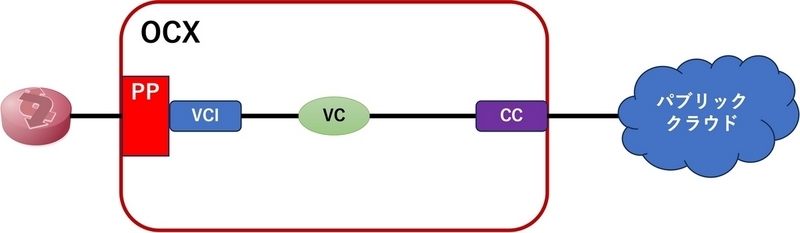

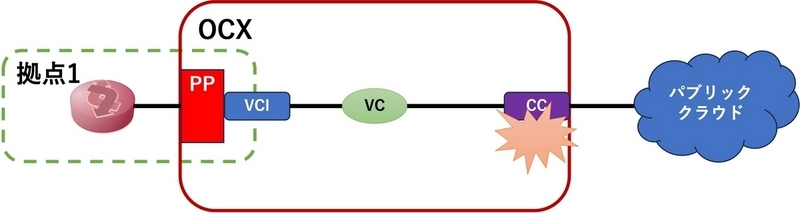

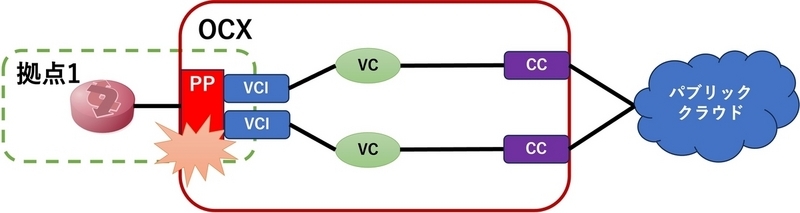

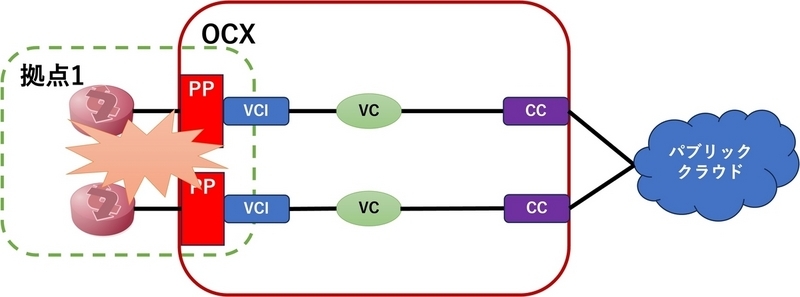

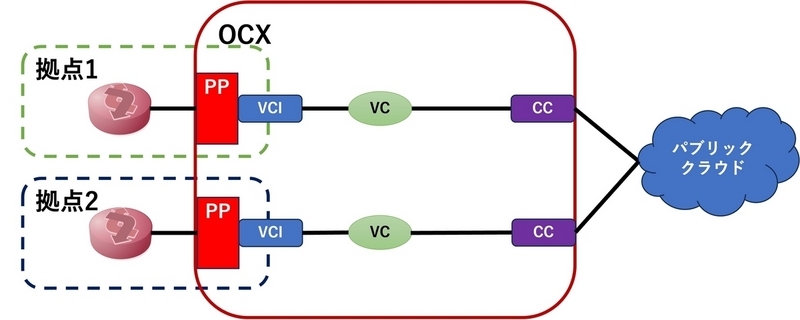

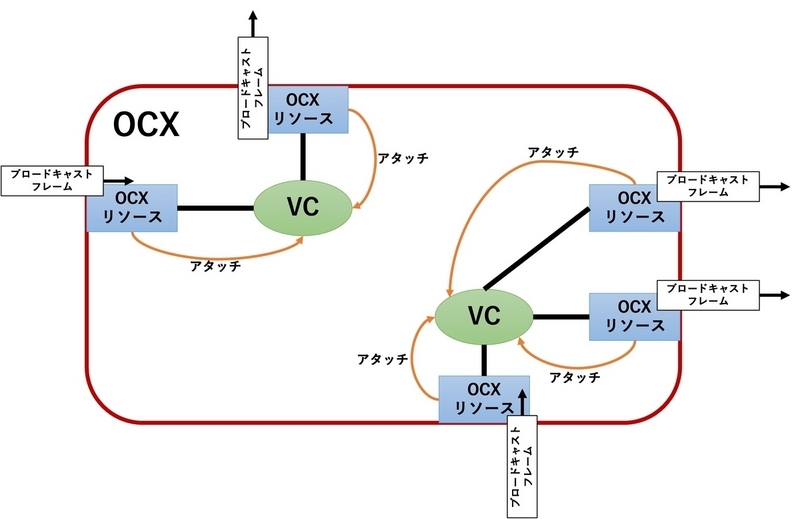

BBSakura Networks(以降 "BBSakura" と書きます)は、親会社が提供している Open Connectivity eXchange (OCX) やさくらのセキュアモバイルコネクト などを開発・運用している、エンジニアの比率が高い会社です。

記事を書くのは みずき@n0mzk です。 ふだんはモバイル開発グループという組織でモバイルコアの開発・運用をしていますが、その傍ら技術広報活動もしています。

去年のアドベントカレンダー以降、この BBSakura Networks Blog をどうやって更新し続けてきたかをお伝えします。

継続までの歴史

BBSakura のブログは 2019 年にアドベントカレンダーをやるために作られました。しかしその後は更新されないままの状態が続き、昨年のアドベントカレンダーで更新再開しました。

せっかく再開したので継続しようとアドベントカレンダー終了ごろから取り組みはじめました。

~ 2023 年 1 月

ブログ継続の機運に乗って、ブログ執筆やイベント参加・登壇などの対外発信活動を支援する「技術広報チーム」を立ち上げました。アドベントカレンダーの参加呼びかけやレビューなどに積極的に関わっていたメンバーが集まったチームです。

2023 年 12 月現在、技術広報チームは 5 人体制で、リーダーの私も含め全員が本業はプロダクトを開発するエンジニアです。技術の話題を扱うので、エンジニアで構成するようにしています。

だれかから任命されるのではなく、会社にとって必要と感じることを自発的にやれるのが BBSakura の良いところなのです。

またちょうどこのころはてなブログ 企業技術ブログコミュニティの存在を知って、BBSakura ブログもはてなブログ for DevBlog に引っ越しました。

ブログ引越しについてはテックリードの日下部が記事を書いています。

この記事でも、

以前のブログは、 2019年にアドベントカレンダー をやるために立てたブログですが、その後、 2022年のアドベントカレンダー をやるまで、全く記事が書かれることがありませんでした。 今後はそのようなことがないように、また、外から見たら何をやっている会社かよくわからないと言われなくなるように、記事を書いていきたいと思っています。

はてなブログ for DevBlogに引っ越しました - BBSakura Networks Blog

と決意表明がされています。

~ 5 月

この時期は、公開社内勉強会の開催について、社外イベントに参加したことについての記事などが公開されています。

これらの記事は、私を含め、社外発信経験のある技術広報チームメンバーが頑張って書いていました。

6 月

しかし、技術広報チームメンバーだけが頑張るのではなく、もっと全社で取り組める持続可能な形にしたかったし、そのほうが BBSakura が扱っているさまざまな技術について有意義な記事を書けると感じはじめ、作戦会議を開きました。

また、BBSakura の注力プロダクトである OCX の開発に携わるメンバーが技術広報チームにいないことも課題に感じていたため、OCX の開発に携わっていて、かつ、対外発信活動を支援したい想いを持っていたメンバーを技術広報チームに誘って加入してもらいました。

この作戦会議とメンバー追加を経てそれ以降の執筆支援体制ができ上がってきました。

いまは月に 1 回技術広報チームの定例会を開き、その中でブログに書けそうなネタのリストアップと執筆の適任者探しをしています。適任と思うメンバーにそのネタについての執筆依頼を行い、書いてもらう、というサイクルです。

このやりかたでこの時期以降は月に 2 記事ぐらいずつ公開を続けられています。

うまく回りだすまでの試行錯誤を経ていま実践している工夫を、以下に紹介します。

継続のために工夫していること

書くハードルを下げる工夫

技術広報チームの活動を知ってもらう

会社として対外発信活動を推進しているんだということを社員みんなに知ってもらうことで、ブログ執筆の依頼もしやすくなるだろうと考えました。

週 1 回各プロジェクトからの進捗報告が行われる全社定例の時間で、技術広報チームも時間をもらって活動報告をするようにしました。

「こんな記事が公開されました」、「次はこういう内容の記事を依頼中です」など、毎週アップデートを全社にお伝えしています。依頼中の記事について「この人にお願いしています」と言うのはなんだか催促するように聞こえてしまうので、やめました。

毎週報告をしていることで、自発的に記事を書いてくれる人も出てくるし、執筆依頼したときのいきなり感も減っているのではないかと感じています。

書き方を周知する

ブログの書き方は、社内の情報蓄積ツール Kibela 上に記載して、毎週の報告のときに「ここを見て書いてください」と伝えています。

書きたくなったときに技術広報チームに書き方を問い合わせるところからスタートではハードルが上がってしまうので、情報をまとめて参照しやすい場所に置くようにしています。

依頼するときの工夫

ネタと適任者を探して依頼する

全体に対して「みんな書いてねー」と言って書いてくれる人はほんの一部の書き慣れている人だけでした。

この人に書いてほしいと思って名指しで「何か書いてよ」とお願いしても、依頼された人はネタを考えるところからのスタートになるため書くまでの道程が長くなってしまい、公開までなかなか至れませんでした。

そういううまくいかない依頼を経て、いまの、ネタを探してから適任者を探して依頼するスタイルにたどりつきました。

ネタを探すためには自分の携わっている業務だけでなく他部署の他プロダクトの動向にもアンテナを張っている必要があります。私は Slack のほぼ全てのチャンネルに参加して、機能リリース予定や技術トピックを追ってネタをストックしています。

いろんな人に依頼する

依頼する相手はなるべくいろんな人にしています。ただ記事数を増やすことだけを目的にしているのではなく、社内のエンジニアたちに対外発信経験を積んでほしい、そのメリットを感じてほしいという想いも持って活動しているので、新入社員や若手を中心に対外発信経験のすくないメンバーに積極的に声を掛けるようにしています。

それによって発信できる内容の幅が広がっているし、一度書いた人は今後も発信活動をしてくれて、その人の成長にも会社のアピールにもつながると思っています。

依頼しっぱなしにしない

依頼を引き受けてくれても、日々の業務が忙しいとブログ執筆のことは忘れられてしまいがちです。

引き受けてもらったあとは、ときどき状況確認をするようにしています。

ただ、急かされている・責められているというふうには捉えてもらいたくないので「急かしているわけじゃないんだけど、その後どうですか。今後の記事公開の計画の参考にしたいので状況教えてください。もし困ってることがあればいつでも声かけてください」というような聞き方をしています。

何度か声を掛けているとだんだんみんな「○日ごろまでに構成を作ります」、「今月中に第 1 稿書けます」などと自分で期日を切って進めてくれるようになってきます。

ときどきリマインドなしですぐに書き上げてくれる人もいて、依頼したこちらがびっくりすることもあります。

引き受けてもらえなくても落ち込まない

それぞれ業務があるなか別のことを依頼しているので、依頼を断られることも当然あります。落ち込んだりせず、「また今度タイミング合うときにお願いします!」で終わりです。

記事レビューの工夫

細かい指摘をしすぎない

未リリースの案件などの出してはいけない内容、利用する画像などの権利、大きな誤字脱字、意味が違って捉えられそうな箇所などは必ず指摘しますが、文体や接続詞の使い方などの細かいところ、記事の構成や内容の取捨選択などの根本的なところは執筆者の個性でもあるので、求められない限りはあまり指摘しない方針です。

細かいところまで指摘しすぎると、次回書く気が起きなくなってしまうからです。

また、公開完了後に執筆者にレビューの感想を聞いてチーム内で対応を見直すこともしています。

良かった点を伝える

せっかく書いてくれた文章に対して修正箇所の指摘だけを行うのはモチベーションが下がるかもしれないと思って、書いてくれた感謝・感想・良かったところをまず伝えるようにしています。

執筆者がどう感じているかはわかりませんが、ブログ記事を書くことがすこしでも良い体験だったと感じてもらえるといいなと思ってやっています。

連載企画

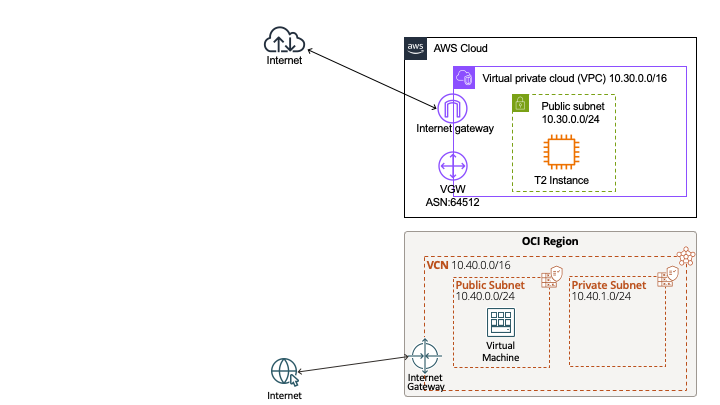

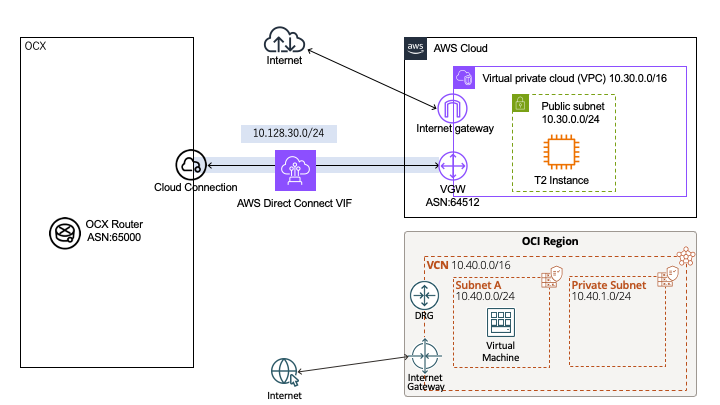

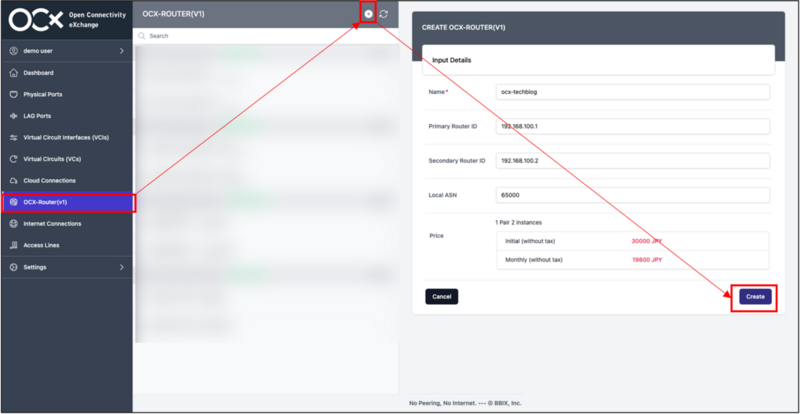

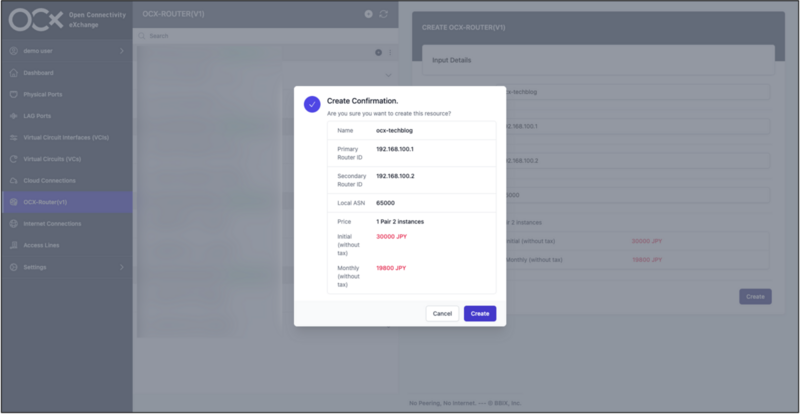

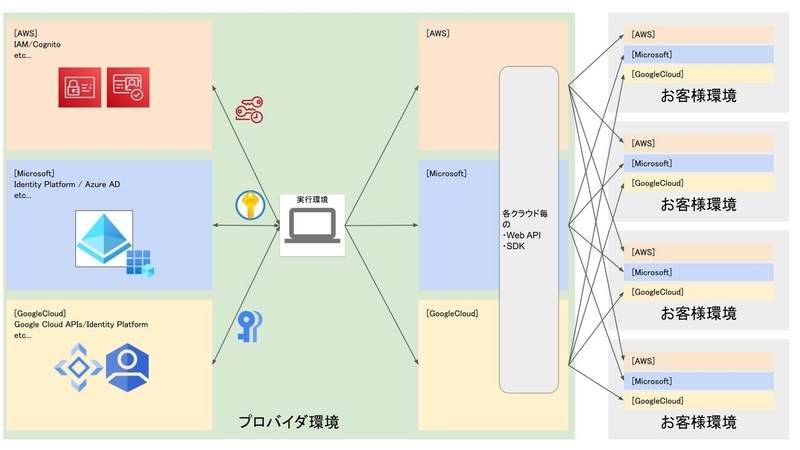

8 月から「#OCXを支える技術」という連載企画をやっています。

会社の注力プロダクトである OCX をアピールしてほしいという社長のコメントがあったこと、OCX 開発に関わるメンバーから「OCX で使われている技術についてシリーズ化するとよさそう」というコメントがあったことで連載がスタートしました。

連載を始めるにあたって開発メンバーに集まってもらってどういう視点で切り取れるか相談する会を開きました。技術広報メンバーだけではシリーズ化できるほど細かい切り口を見つけられなかったので、現場で開発しているメンバーに協力してもらえたのはとても助かりました。

情報を出せる時期、メンバーの手が空きそうな時期を見ながら、ある程度のペースで出せるように依頼していっています。

番外編: アクセシビリティの理解推進

工夫とはちょっと違うのですが私が企業公式ブログを運営するにあたって気にしていることのひとつにアクセシビリティがあります。

画像には代替テキストをつける、画像の色にコントラストをつけるなど、なるべく多くの人に情報を届けられる記事にするための意識をしています。

アクセシビリティについても Kibela ページに記載しているのですが執筆時点ではそれらを気にしていない人も多いので、レビューのときに修正をお願いしています。

アクセシビリティをみんなに意識してもらえるよう推進したいという想いがあるので、私が勝手に代替テキストをつけるのではなく、執筆者本人に、どういうテキストをつければ音声のみでも伝わるのか考えてもらうようにしています。

おわりに

技術ブログの更新を継続できるようになるまでの道のりと、継続のために行っている工夫についてお伝えしました。

技術広報チームはブログの運営だけでなく、登壇支援や公式 SNS アカウントの運営なども行っています。

これらの活動を通して私は会社のことをよりよく知れる 1 年だったなと感じています。

どのプロダクトで、いつ、どんな機能がリリースされるのか。どんなプレスリリースを出すのか。社内のエンジニアそれぞれが、どんなプロダクトのどの分野で、どんな機能を開発しているのか、運用しているのか。どういう考え、主義主張を持って仕事しているのか。各プロダクトではどんな技術が使われているのか、どんな挑戦があるのか。

自分の担当業務を行っているだけでは触れなかったであろう情報、キーワードがたくさん出てくるし、ふだん関わる機会のないメンバーとも会話できるきっかけになり、すごくワクワクする活動です。

自分が本業で担当している開発についても、会社全体の戦略の中でどこに位置していて他のなにと強く関係するのか、理解が深まったと感じています。

企業ブログの運営をしている人、技術広報担当者、社外への発信をしていきたい人たちに、なにか参考になったり、楽しそうと思ってもらえたりしたら嬉しいです。

明日からも毎日アドベントカレンダー記事が投稿される予定ですので、引き続き楽しみにお待ちください!